技術分享

[技術分享] NonStop Interconnect採用InfiniBand的架構特性與優勢

作者/王宜倫

作者簡介作者擁有27年以上IT服務資歷,現職凌群電腦NSK服務總處總處長,主要負責NonStop系統維運服務、軟體產品整合服務。專長為HPE NonStop系統、系統整合、系統網路監控管理及專案管理。

前言

HPE NonStop融合其獨特的設計與業界標準的軟硬體技術,提供用戶極致的不停頓高效能運算體驗;自NonStop X系列開始導入InfiniBand技術,藉由InfiniBand的通訊卸載(offload)、先進的壅塞控制(congestion control)、高處理量和低延遲等特性,大幅提升其系統內部網路(Interconnect)之效能,推升整體運算能力。本篇文章將針對NonStop採用InfiniBand作為Interconnect的相關技術進行說明。

NonStop系統內部網路Interconnect演進

早期NonStop系統使用專屬設計的匯流排(bus)連接系統間所有的CPU,此匯流排稱為”Dynabus”,系統內CPU藉由此”Dynabus”進行資料傳輸;而CPU與周邊儲存和通訊設備則透過另一專屬設計的I/O bus進行資料傳輸。此架構設計自第一代的NonStop I一直沿用到1990年代中期的NonStop Himalaya K-series;當然,隨著新技術的發展,Dynabus也由舊世代匯流排演進到光纖技術。

在1990年代,HPE (當時為Tandem)開始發展稱為ServerNet的新的Interconnect技術,ServerNet整合Dynabus與I/O bus,採用點對點與wormhole 傳輸機制,建立System Area Network (SAN)的Interconnect架構,增加傳輸路由並提升頻寬,解決了過去匯流排架構效能不佳的問題;1997年推出新一代的S-series主機採用此ServerNet技術,當時也大幅提升了整體效能,此ServerNet架構自S7000/S70000開始到NB56000主機,使用近20年,ServerNet頻寬也由最初的ServerNet I 50MB/s提升到第三代的ServerNet III 250MB/s,但隨著運算需求的不斷提升,ServerNet技術已無法支持高速成長的運算需求。

HPE於2015年推出NonStop X系統,Interconnect採用標準的InfiniBand與RDMA技術,解決前幾代系列主機Interconnect的效能瓶頸,大幅提升系統整體運算效能。NonStop X NS7/NS3系列採用56Gbps FDR InfiniBand,最新的NS8/NS4系列採用100Gbps HDR InfiniBand。

NonStop Interconnect採用InfiniBand的主要原因

要探究NonStop系統Interconnect採用infiniBand的原因,有以下6項重要因素:

一、Data Integrity (資料一致性):

NonStop系統架構最主要基石之一是資料一致性,InfiniBand藉由在fabric hop以及跨fabric點對點都進行CRC檢查,確保傳輸過程資料一致性。

二、Fault Tolerance (容錯):

InfiniBand網路具備多fabric的特性,NonStop OS提供在不同fabric間切換的機制,確保資料傳輸的容錯能力。

三、Bandwidth/Latency:

InfiniBand提供高頻寬和低延遲的特性,滿足有高I/O導向的應用系統需求。

四、RDMA:

RDMA移除資料傳輸過程中OS kernel的介入處理,有效提升處理效率,降低延遲時間。

五、Clustering/Long Distance:

多個NonStop系統可使用InfiniBand做cluster,並藉由DWDM進行遠距連結(最遠達56公里)。

六、InfiniBand是ServerNet的升級版:

InfiniBand與NonStop ServerNet具備相同的資料一致性、容錯與高可用性等基礎特性,並提供更高的頻寬與更低的延遲時間;InfiniBand與NonStop作業系統底層設計採用類似技術,例如:容錯架構、點對點資料傳輸、直接大量資料傳送(direct bulk data transfer)等,因此,作業系統架構無須大幅重新設計,對用戶的應用系統也無影響,NonStop可順利的轉換到InfiniBand。

NonStop InfiniBand Interconnect硬體架構

一、NS7/NS3系列

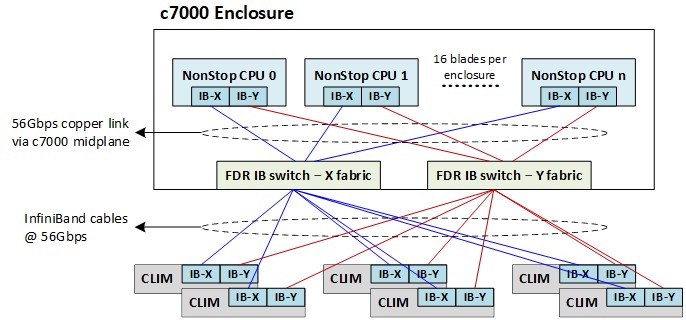

1.NS7/NS3系列主機採用HPE blade架構,使用c7000機架;c7000機架安裝一組56Gbps FDR InfiniBand switch,並使用獨立的X/Y fabric來達到容錯能力。

2.每個CPU blade安裝一片2 port FDR InfiniBand HCA (Host Channel Adapter),每個port分別連接至c7000機架內X/Y fabric的InfiniBand switch。

3.每個儲存設備(Storage CLIM)與網路設備(IP CLIM)安裝一片2 port FDR InfiniBand HCA,每個port分別連接至c7000機架內X/Y fabric的InfiniBand switch;若CLIM數量超過16台,可透過I/O Expansion switch擴充,c7000 blade InfiniBand switch與I/O Expansion switch間的頻寬為56Gbps。

4.NS7/NS3 InfiniBand Hardware架構如下圖:

二.NS8/NS4系列

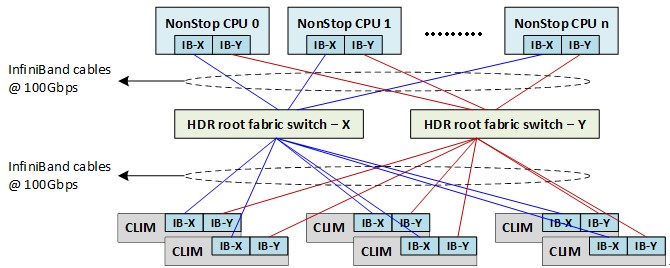

1.NS8/NS4系列主機採用HPE rack-mount架構;使用一組HDR InfiniBand root fabric switch。

2.每個CPU server安裝一片2 port HDR InfiniBand HCA,每個port分別連接至X/Y root fabric switch。

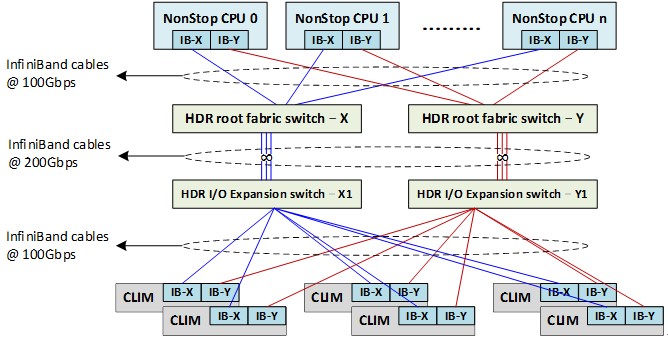

3.每個儲存設備(Storage CLIM)與網路設備(IP CLIM)安裝一片2 port HDR InfiniBand HCA,每個port分別連接至X/Y root fabric switch;若CLIM數量超過16台,可透過I/O Expansion switch擴充,root fabric switch與I/O Expansion switch間的頻寬為200Gbps。

4.NS8/NS4 InfiniBand Hardware架構如下圖:

5.NS8/NS4 InfiniBand Hardware架構(含1組HDR I/O Expansion switch)如下圖:

NonStop InfiniBand Interconnect軟體架構

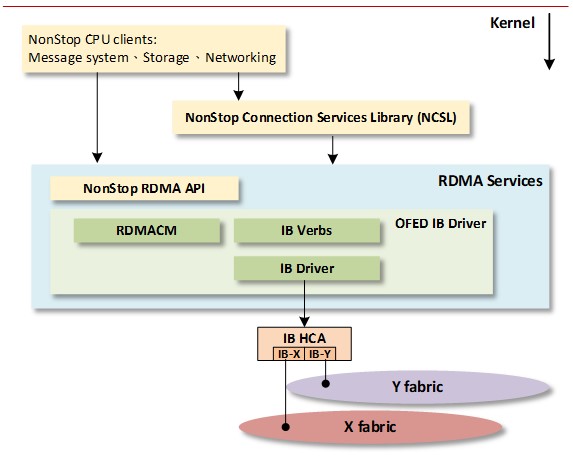

1.RDMA Services:NonStop OS提供新的RDMA Services模組,主要包含RDMA使用的IB Verbs與最底層的InfiniBand driver;CLIM相對應的模組使用標準OFED InfiniBand driver,OFED (Open Fabrics Enterprise Distribution)隸屬於OpenFabrics Alliance。

2.NCSL (NonStop Connection Services Library):此模組位於“RDMA services”上層,提供fabric容錯功能、錯誤偵測、連線建立與控制訊息流;NonStop作業系統與CLIM藉由此模組使用底層的RDMA services。

3.用戶的應用系統程式使用NonStop作業系統的服務,沒有直接面對InfiniBand,所以對應用系統是透通的,不須額外了解InfiniBand與RDMA。

4.NonStop作業系統與資料傳輸相關的Message system、Storage與Networking會藉由NCSL與RDMA services進行資料傳輸,亦即在NonStop系統內部CPU與CPU間的資料傳輸、對S

torage CLIM的I/O,以及對IP CLIM的資料傳輸,其底層實際運作均是採用RDMA的機制。

5.NonStop X InfiniBand host端software架構示意圖如下:

結論

InfiniBand為端對端的高效能網路,其資料一致性、容錯、架構簡單、高處理容量與低延遲等特性,非常適合用於HPC、AI、科學運算與大型雲端架構;依據2022年6月的統計資料,全球TOP500 Supercomputer中,有197個系統使用InfiniBand作為Interconnect,較去年成長了16%;而前100大中,更有高達62個系統採用InfiniBand。NonStop導入InfiniBand作為Interconnect也大幅提升整體效能;目前NS8/NS4採用100Gbps HDR InfiniBand技術,InfiniBand製造商NVIDIA最新一代的ConnectX-7 HCA更將效能推升至400Gbps,可預見NonStop使用InfiniBand與RDMA技術,可持續滿足更具挑戰性的工作負載。

參考資料

(1)https://www.nvidia.com/zh-tw/networking/products/infiniband/

(2)https://nvdam.widen.net/s/xrksv8dqpb/top500-interconnect-trends-june2022

(3)https://en.wikipedia.org/wiki/InfiniBand

(4)https://en.wikipedia.org/wiki/Tandem_Computers

(5)Marcelo de Azevedo & Michael Chan, "NONSTOP INTERCONNECT FABRICS TECHNICAL UPDATE", 2020 NonStop TBC

(6)Michael Rice, "HPE NonStop X on x86 InfiniBand Technical Overview", 2015 NonStop TBC