技術分享

[技術分享] NonStop InfiniBand維運實務經驗分享

作者/馬年裕

作者簡歷作者擁有13年IT服務資歷,現任凌群電腦專案經理,主要負責NonStop系統及InfiniBand網路維運管理,專長為HPE NonStop與周邊系統及網路整合。

前言

InfiniBand技術,縮寫為IB,是一個用於高效能處理計算的電腦網路通信標準,它的優勢在於高頻寬和低延遲,主要用於主機與主機之間的資料傳輸連接,也可以用於主機與儲存系統之間或是儲存系統之間的連接。

InfiniBand網路簡介

InfiniBand的網路像一般Ethernet的網路環境一樣,主機與主機之間的連結需要透過網路交換器(Switch)、網路線(Cable)以及網路介面卡組成。最主要的差異是在於InfiniBand網路中一定要啟動一個(或以上) Subnet Manager(SM),如果InfiniBand網路沒有任何的Subnet Manager啟動,這個網路則無法運作;Master SM(註記1)負責啟動InfiniBand網路內的介面以及計算路由,Subnet Manager功能可運行於InfiniBand Switch上。

註記1:當InfiniBand網路中有多個Subnet Manager時,可透過 sm-priority參數來控制優先權,數字最高的Subnet Manager優先啟動成為Master狀態,而其他Subnet Manager則處於Standby狀態,當發現最高的Subnet Manager離開網路後,則優先權次高的Subnet Manager就會變成Master狀態。

HPE NonStop X系列主機使用InfiniBand取代以前的ServerNet內部網路,CPU與其他元件之間的網路,像是儲存區(Storage CLIM),網路介面(Network CLIM)或是InfiniBand網路介面(LL-CLIM, Low Latency CLIM)均是用InfiniBand網路串聯起來,網路介面頻寬可達到NS7/NS3的56Gbps或NS8/NS4的100Gbps,具有高效能的網路傳輸能力,在未來也有更大的發展空間(目前InfiniBand可支援的速率規格已經可以到達200Gbps HDR以上)。

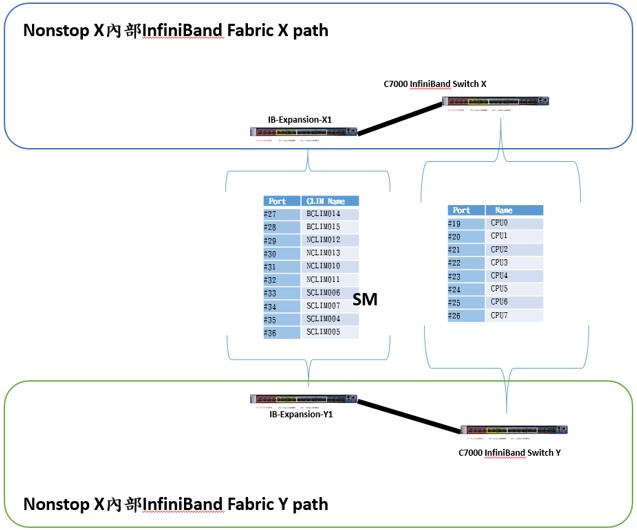

NonStop X主機的內部InfiniBand網路組成

NonStop X主機的內部InfiniBand網路主要由Fabric X Path & Fabric Y Path所組成,Fabric X path及Fabric Y path是各自獨立的InfiniBand網路,由各自Fabric的Subnet Manager管理,而每個元件(CPU及CLIM等)都會連接到這兩個不同Fabric Path,所以即使有一個Fabric Path的網路出現異常,NonStop X主機還是可以正常運作。架構圖如下:

NonStop X主機的外部InfiniBand網路組成

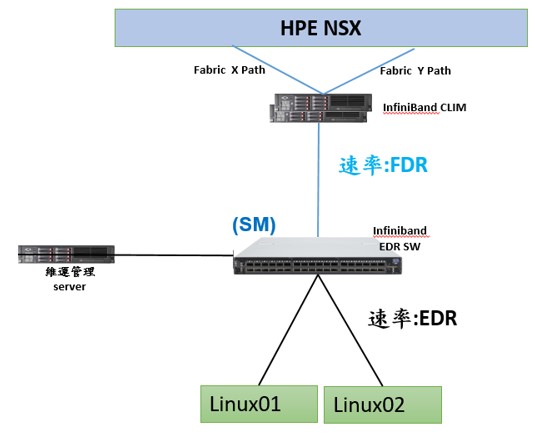

HPE NonStop X主機對外也提供了InfiniBand介面(LL-CLIM)連接外部的InfiniBand網路。如下圖,NonStop X主機透過LL-CLIM連接InfiniBand Switch,當HPE NonStop X主機端速率為56Gbps(FDR),而Linux 端為100Gbps(EDR),兩邊的速率不一致時,則Subnet Manager會針對兩端點所支援的最大速度運行(SPEED NEGOTIATION)。

NonStop X主機支援IP over IB(Internet Protocol over InfiniBand)的通訊協議來進行資料傳輸,是基於InfiniBand (底層)上的IP網路,IP over IB定義了InfiniBand網路介面卡(HCA)如何處理將主機端的IP資料封包轉換至InfiniBand網路上,而對點的InfiniBand網路介面卡(HCA)則是將收到的InfiniBand資料封包轉換成IP資料封包,這種方式,可不需調整使用者的IP網路使用習慣,又可以體驗到InfiniBand網路的效能。架構圖如下:

NonStop X InfiniBand內部/外部網路檢查方式

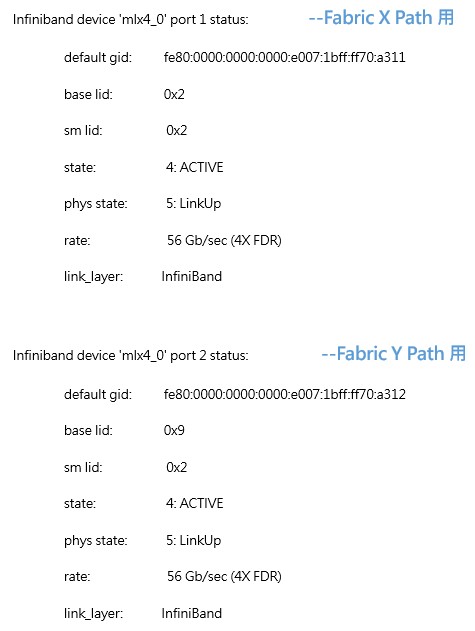

一、InfiniBand網路介面卡檢查

指令: ibstatus

顯示該主機上InfiniBand網路介面卡的狀態

範例:如下結果顯示有兩個InfiniBand介面,主要是連接NonStop X系統的Fabric X Path and Fabric Y Path用。

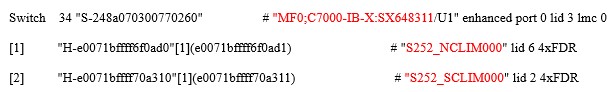

二、InfiniBand網路架構檢查

指令:ibnetdiscover

檢查NonStop X內部/外部InfiniBand網路內所有設備的及介面速率

範例:顯示該InfiniBand網路中的CPU or CLIM設備的介面狀態,以及連接的InfiniBand Switch 位置。

三、InfiniBand Subnet Manager狀態檢查

指令:sminfo

檢查NonStop X內部/外部的Subnet Manager在哪個設備上

四、NonStop X InfiniBand介面狀態檢查

除了NonStop系統的OSM會定期執行內部Fabric X & Y的InfiniBand Path test以及使用者可手動連到InfiniBand Switch的管理介面檢查每個介面資訊外,亦可透過Script的方式自動收集內部IB Switch每個介面的狀態資訊,再依照檢查項目需求將資料過濾處理後(包含每個CPU及CLIM的Fabric X Path及Fabric Y Path介面)產生report。

檢查項目範例:

‧檢查每個InfiniBand介面的error counters。

‧檢查每個InfiniBand介面的速率及狀態。

‧檢查每個InfiniBand架構或是其他介面資訊等。

五、收集InfiniBand Switch dumpfile

當InfiniBand Switch設備或是介接的InfiniBand網路的連線發生異常需要請原廠協助時,可以透過InfiniBand Switch的管理介面收集dumpfile,提供給原廠分析問題原因。

收集方式:

1.使用putty ssh連線登入InfiniBand Switch CLI畫面

2.輸入帳密,登入Switch CLI介面

3.登入switch後,輸入指令”enable & conf t“ 進入config mode

4.輸入指令:“debug generate dump”

5.將dumpfile上傳至SFTP Server(需啟動SFTP service)

6.上傳檔案指令:

file debug-dump upload latest sftp://username:password@xx.xx.xx.xx/root/)

參考資料

1.Marcelo de Azevedo,"NONSTOP INTERCONNECT FABRICS TECHNICAL UPDATE", 2020 NonStop TBC

2.InfiniBandTM Architecture Specification(IBTA 1.1~IBTA1.4)

3.維基百科:InfiniBand(https://zh.wikipedia.org/zh-tw/InfiniBand)

4.NVIDIA Mellanox MLNX-OS User Manual (https://docs.nvidia.com/networking/category/mlnxos)